- In:

- Posted By: Capuano Edoardo

- Commenti: 0

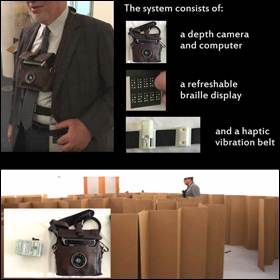

Il sistema fornisce informazioni da una fotocamera 3D, tramite motori vibranti e un'interfaccia Braille.

Gli scienziati informatici lavorano da decenni sui sistemi di navigazione automatica per aiutare i non vedenti, ma è stato difficile trovare qualcosa di affidabile e facile da usare come il bastone bianco con la punta di metallo che le persone ipovedenti usano spesso per identificare eventuali ostacoli mentre camminano. Tuttavia, questo tipo di bastone presenta alcuni inconvenienti: gli ostacoli con cui entra in contatto sono a volte altre persone; non riesce a identificare determinati tipi di oggetti, come tavoli o sedie, o determinare se una sedia è già occupata da un'altra persona.

I ricercatori del MIT Computer Science and Artificial Intelligence Laboratory (CSAIL)(1) hanno sviluppato un nuovo sistema che utilizza una telecamera 3D, una cintura con motori vibrazionali controllabili separatamente e un'interfaccia Braille riconfigurabile elettronicamente per offrire agli utenti non vedenti più informazioni su i loro ambienti.(2) Il sistema potrebbe essere utilizzato in combinazione con o come alternativa a un bastone.

“Abbiamo fatto un paio di test diversi con utenti non vedenti”, afferma Robert Katzschmann,(3) uno studente laureato in ingegneria meccanica al MIT e uno dei primi due autori del progetto. “Disporre di un dispositivo che non alterava gli altri sensi era importante. Quindi non volevamo avere audio; non volevamo avere qualcosa intorno alla testa, vibrazioni sul collo - tutte queste cose, le abbiamo provate, ma nessuna di queste è stata accettata. Abbiamo scoperto che l'unica area del corpo che è meno utilizzata dagli altri sensi è intorno all'addome”.

Analizzando il mondo

Il sistema dei ricercatori consiste in una fotocamera 3-D indossata in una custodia appesa al collo; un'unità di elaborazione che esegue gli algoritmi proprietari del team; la cintura del sensore, che ha cinque motori vibranti distribuiti uniformemente attorno alla sua metà anteriore; l'interfaccia Braille riconfigurabile, che viene indossata dal lato dell'utente.

La chiave del sistema è un algoritmo per identificare rapidamente le superfici e i loro orientamenti dai dati della fotocamera 3D. I ricercatori hanno sperimentato tre diversi tipi di fotocamere 3D, che utilizzavano tre diverse tecniche per misurare la profondità, ma tutte producevano immagini a bassa risoluzione - 640 pixel per 480 pixel - con misurazioni di colore e profondità per ciascun pixel.

L'algoritmo raggruppa prima i pixel in gruppi di tre. Poiché i pixel hanno associati i dati di posizione, ciascun cluster determina un piano. Se gli orientamenti dei piani definiti da cinque gruppi vicini si trovano entro 10 gradi l'uno dall'altro, il sistema conclude che ha trovato una superficie. Non ha bisogno di determinare l'estensione della superficie o di quale tipo di oggetto è la superficie. Registra semplicemente un ostacolo in quel punto e il motore associato inizia a ronzare nel momento in cui l'utente arriva a 2 metri di distanza dall'ostacolo. L'identificazione della sedia è simile ma un po' più rigorosa. Il sistema deve completare tre distinte identificazioni di superficie, nella stessa area generale, piuttosto che una sola; questo assicura che la sedia non sia occupata. Le superfici devono essere approssimativamente parallele al terreno e devono rientrare in un intervallo di altezze prestabilito.

Dati tattili

I motori della cinghia possono variare la frequenza, l'intensità e la durata delle loro vibrazioni, nonché gli intervalli tra loro, per inviare all'utente diversi tipi di segnali tattili. Ad esempio, un aumento di frequenza e intensità indica generalmente che chi lo indossa si sta avvicinando a un ostacolo nella direzione indicata da quel particolare motore. Ma quando il sistema è in modalità di rilevamento della poltrona, ad esempio, un doppio impulso indica la direzione in cui è disponibile una sedia con un posto libero.

Le prove del dispositivo hanno fornito i seguenti risultati: il sistema di ricerca della sedia riduceva i contatti dei soggetti con oggetti diversi dalle sedie ricercate dall'80% mentre il sistema di navigazione riduceva il numero di collisioni con le persone che gironzolavano in un corridoio dell'86%.

Riferimenti:

(1) MIT Computer Science & Artificial Intelligence Lab

(2) Wearable system helps visually impaired users navigate

Autore: Edoardo Capuano / Foto: MIT