- In:

- Posted By: Capuano Edoardo

- Commenti: 0

Sviluppata una tecnica di apprendimento automatico che cattura e modella accuratamente l'acustica sottostante di una scena da un numero limitato di registrazioni sonore

Immagina gli accordi rimbombanti di un organo a canne che echeggiano attraverso il santuario cavernoso di una massiccia cattedrale di pietra.

Il suono che sentirà un frequentatore della cattedrale è influenzato da molti fattori, tra cui la posizione dell'organo, dove si trova l'ascoltatore, se ci sono delle colonne, i banchi o altri ostacoli che si frappongono tra di loro, di cosa sono fatte le pareti, la posizione di finestre o porte, ecc. Ascoltare un suono può aiutare qualcuno a immaginare il proprio ambiente.

I ricercatori del Massachusetts Institute of Technology e del MIT-IBM Watson AI Lab stanno esplorando l'uso delle informazioni acustiche spaziali per aiutare anche le macchine a immaginare meglio i loro ambienti. Hanno sviluppato un modello di apprendimento automatico in grado di catturare il modo in cui qualsiasi suono in una stanza si propagherà nello spazio, consentendo al modello di simulare ciò che un ascoltatore udrebbe in luoghi diversi.

Modellando accuratamente l'acustica di una scena, il sistema può apprendere la geometria 3D sottostante di una stanza dalle registrazioni sonore. I ricercatori possono utilizzare le informazioni acustiche che il loro sistema acquisisce per costruire rendering visivi accurati di una stanza, in modo simile a come gli esseri umani usano il suono quando stimano le proprietà del loro ambiente fisico.

Oltre alle sue potenziali applicazioni nella realtà virtuale e aumentata, questa tecnica potrebbe aiutare gli agenti di intelligenza artificiale a sviluppare una migliore comprensione del mondo che li circonda. Ad esempio, modellando le proprietà acustiche del suono nel suo ambiente, un robot di esplorazione subacquea potrebbe percepire cose che sono più lontane di quanto potrebbe con la sola vista, afferma Yilun Du, una studentessa laureata presso il Dipartimento di Ingegneria Elettrica e Informatica (EECS) e coautrice di un articolo che descrive il modello.

«Finora la maggior parte dei ricercatori si è concentrata solo sulla modellazione della visione. Ma come esseri umani, abbiamo una percezione multimodale. Non solo la vista è importante, anche il suono è importante. Penso che questo lavoro apra un'entusiasmante direzione di ricerca sull'utilizzo migliore del suono per modellare il mondo», afferma Du.

Suono e visione

Nella ricerca sulla visione artificiale, un tipo di modello di apprendimento automatico chiamato modello di rappresentazione neurale implicita è stato utilizzato per generare ricostruzioni fluide e continue di scene 3D dalle immagini. Questi modelli utilizzano reti neurali, che contengono strati di nodi interconnessi, o neuroni, che elaborano i dati per completare un'attività.

I ricercatori del MIT hanno utilizzato lo stesso tipo di modello per catturare il modo in cui il suono viaggia continuamente attraverso una scena.

Ma hanno scoperto che i modelli visivi beneficiano di una proprietà nota come consistenza fotometrica che non si applica al suono. Se si guarda lo stesso oggetto da due posizioni diverse, l'oggetto appare più o meno lo stesso. Ma con il suono, cambiare posizione e il suono che si sente potrebbe essere completamente diverso a causa di ostacoli, distanza, ecc. Ciò rende molto difficile prevedere l'audio.

I ricercatori hanno superato questo problema incorporando due proprietà dell'acustica nel loro modello: la natura reciproca del suono e l'influenza delle caratteristiche geometriche locali.

Il suono è reciproco, il che significa che se la sorgente di un suono e un ascoltatore si scambiano posizione, ciò che la persona sente rimane invariato. Inoltre, ciò che si sente in una determinata area è fortemente influenzato da caratteristiche locali, come un ostacolo tra l'ascoltatore e la fonte del suono.

Per incorporare questi due fattori nel loro modello, chiamato campo acustico neurale (NAF), aumentano la rete neurale con una griglia che cattura oggetti e caratteristiche architettoniche nella scena, come porte o muri. Il modello campiona casualmente i punti su quella griglia per apprendere le caratteristiche in posizioni specifiche.

«Se immagini di stare vicino a una porta, ciò che influenza maggiormente quello che senti è la presenza di quella porta, non necessariamente delle caratteristiche geometriche lontane da te dall'altra parte della stanza. Abbiamo scoperto che queste informazioni consentono una migliore generalizzazione rispetto a una semplice rete completamente connessa», afferma Luo.

Dalla previsione dei suoni alla visualizzazione delle scene

I ricercatori possono fornire alla NAF informazioni visive su una scena e alcuni spettrogrammi che mostrano come suonerebbe un brano audio quando l'emettitore e l'ascoltatore si trovano in punti target della stanza. Quindi il modello prevede come suonerebbe l'audio se l'ascoltatore si sposta in un punto qualsiasi della scena.

Il NAF emette una risposta all'impulso, che cattura come un suono dovrebbe cambiare mentre si propaga attraverso la scena. I ricercatori applicano quindi questa risposta all'impulso a suoni diversi per ascoltare come quei suoni dovrebbero cambiare mentre una persona cammina attraverso una stanza.

Ad esempio, se una canzone viene riprodotta da un altoparlante al centro di una stanza, il loro modello mostrerebbe come quel suono diventa più forte quando una persona si avvicina all'altoparlante e poi diventa attutito mentre escono in un corridoio adiacente.

Quando i ricercatori hanno confrontato la loro tecnica con altri metodi che modellano le informazioni acustiche, hanno generato modelli sonori più accurati in ogni caso. E poiché ha appreso informazioni geometriche locali, il loro modello è stato in grado di generalizzare a nuove posizioni in una scena molto meglio di altri metodi.

Inoltre, hanno scoperto che l'applicazione delle informazioni acustiche apprese dal loro modello a un modello di visione artificiale può portare a una migliore ricostruzione visiva della scena.

«Quando si dispone solo di una serie sparsa di viste, l'utilizzo di queste funzionalità acustiche consente di catturare i confini in modo più nitido, ad esempio. E forse questo è dovuto al fatto che per rendere accuratamente l'acustica di una scena, devi catturare la geometria 3D sottostante di quella scena», afferma Du.

I ricercatori hanno in programma di continuare a migliorare il modello in modo che possa generalizzare a scene nuove di zecca. Vogliono anche applicare questa tecnica a risposte all'impulso più complesse e scene più grandi, come interi edifici o persino una città.

«Questa nuova tecnica potrebbe aprire nuove opportunità per creare un'esperienza immersiva multimodale nell'applicazione del metaverso», aggiunge Gan.

Con la dottoressa Yilun Du hanno lavorato sul documento (1): l'autore principale Andrew Luo, uno studente laureato alla Carnegie Mellon University (CMU); Michael J. Tarr, Professore Kavcic-Moura di Scienze cognitive e del cervello alla CMU; gli autori senior Joshua B. Tenenbaum, Paul E. Newton Career Development Professor of Cognitive Science and Computation presso il Department of Brain and Cognitive Sciences del MIT e membro del Computer Science and Artificial Intelligence Laboratory (CSAIL); Antonio Torralba, Professore di Elettronica e Informatica della Delta e membro di CSAIL; Chuang Gan, uno dei principali membri dello staff di ricerca presso il MIT-IBM Watson AI Lab. La ricerca sarà presentata alla Conferenza sui Sistemi di Elaborazione dell'Informazione Neurale.Questo lavoro è supportato, in parte, dal MIT-IBM Watson AI Lab e dal Tianqiao and Chrissy Chen Institute.

Riferimenti:

(1) Learning Neural Acoustic Fields

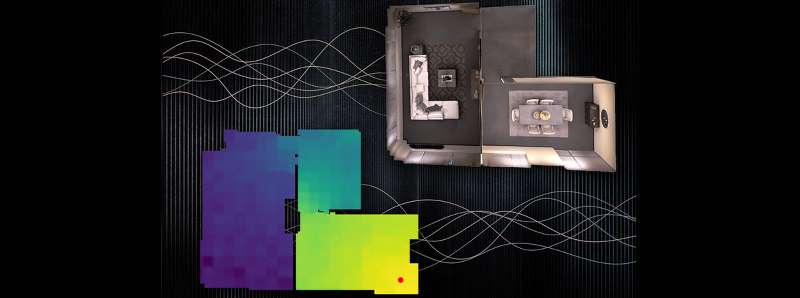

Descrizione foto: I ricercatori del MIT hanno sviluppato una tecnica di apprendimento automatico che cattura e modella accuratamente l'acustica sottostante di una scena da un numero limitato di registrazioni sonore. In questa immagine, un emettitore di suoni è contrassegnato da un punto rosso. I colori mostrano il volume del suono se un ascoltatore si trova in luoghi diversi: il giallo è più forte e il blu è più silenzioso. - Figura per gentile concessione di Yilun Du; a cura di MIT News.

Autore traduzione riassuntiva e adattamento linguistico: Edoardo Capuano / Articolo originale: Using sound to model the world